目次

インターネットが当たり前となった現在、ビジネスだけでなく、日常生活においても様々なデータを活用する場面が増えています。

「データをもっと効率よく収集したい!」

「データ収集を自動化できないのか?」

と考えたことがある方も多いのではないでしょうか?

データを効率よく収集するための技術の1つが「Webスクレイピング」であり、PythonにはWebスクレイピングを実装するための機能がたくさん備わっています。

この記事では、Pythonを使ったWebスクレイピングについて詳しく解説していきます。

PythonにおけるWebスクレイピングの基礎知識

Pythonには、データを効率よく収集することができる「Webスクレイピング」を実装するための機能がたくさん備わっています。

ここでは、そもそもWebスクレイピングとは一体何なのか、どのように活用されているのか解説していきます。

そもそもWebスクレイピングとは

「Webスクレイピング」とは、WebサイトからHTMLデータを取得し、そのデータを元に必要となる情報を抽出するソフトウェア技術です。

また、PythonのWebスクレイピングでは、情報を収集するだけでなく、不要なデータを除去してExcel形式など、人間が見やすい形に重要なデータを自動で整理することができます。

したがって、Webスクレイピングを利用することで情報収集に費やす時間が削減でき、効率を高めることができます。

スクレイピングとクロールの違い

スクレイピングのようにWebサイトから情報を収集する技術の一つに「クロール」があります。

クロールでは、「クローラー」というソフトウェアが様々なWebサイトを巡回(クローリング)し、内容の解析、情報の収集、保存をします。

両者はWebサイトの情報を収集するという点では同じですが、スクレイピングはデータの加工まで行い、データを見やすい形に整理できるという点で異なります。

スクレイピングの活用方法

近年、企業経営やマーケティング、研究など様々な分野でデータの活用が重要となってきているため、スクレイピングが多くの場面で活用されています。

例えば、機械学習や市場価格の調査、トレンド分析、商品データリサーチなどのデータ収集・整理にスクレイピングが用いられます。

また、企業や機関の業務だけでなく、個人でもスクレイピングを活用することができます。

例えば、ECサイトの情報を収集して最適な商品を探したり、求人サイトから希望する求人情報を効率よく探すことができたりします。

Pythonを使ったWebスクレイピングの手順

Pythonを使って、実際にどのようにWebスクレイピングができるのか、3つの方法に分けて具体的に解説していきます。

自分でプログラムを構築する場合

Pythonを使って、自分でWebスクレイピングのプログラムを構築する場合、ライブラリを活用することになります。

ライブラリとは、プログラムによく使われる機能をまとめたものであり、PythonではWebスクレイピングに役立つライブラリが用意されています。

- Requests:Webページの情報を取得する

- Beautiful Soup:取得したページ情報を解析する

- Selenium:Webページ情報の取得、データの抽出両方が可能

- Scrapy:Webページ情報の取得、データの抽出、保存まで可能

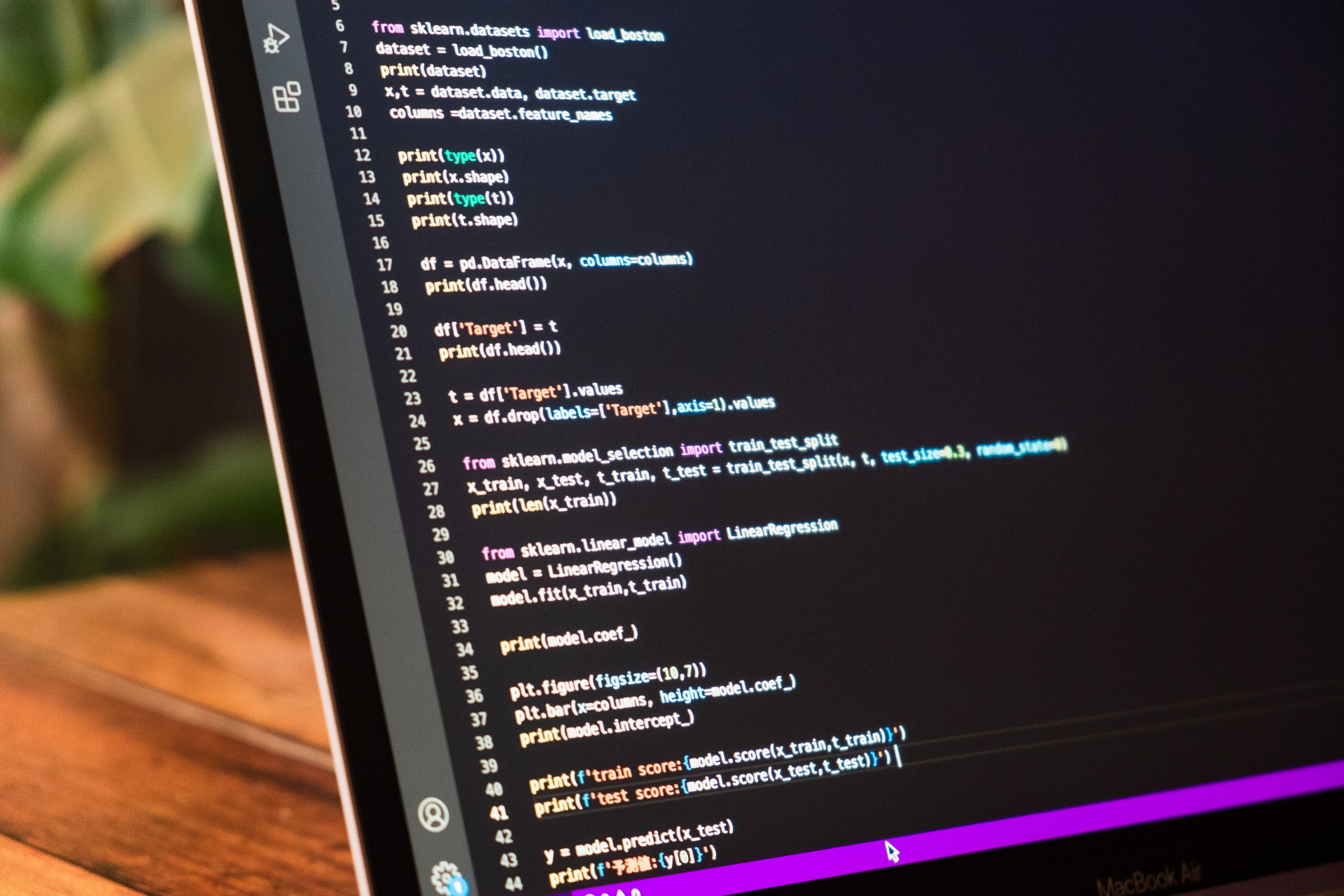

Pythonでは、プログラミングコードにて以下のようにライブラリを取り込むことで、ライブラリのメソッドを利用できるようになります。

有料サービスを使う場合

自身でプログラムを構築しなくても、簡単な操作でWebスクレイピングをすることができる「Webスクレイピングツール」が販売されています。

代表的な有料Webスクレイピングツールには以下のようなものがあります。

- Octoparse:簡単なポイント&クリック操作のみでWebサイトから情報を取得し、ExcelやCSVのような見やすいフォーマットで保存することが可能。GoogleマップやAmazon、Twitterなど様々なサービスに特化したテンプレートも用意されています。

- Mozenda:データの抽出に役立つ機能を備えたクラウドWebスクレイピングツール。ドキュメントだけでなく、画像の抽出も可能で、抽出したデータをDropboxやMicrosoft Azureなどのクラウドデータベースに保存することができます。

無料サービスを使う場合

有料のサービスよりは機能が劣りますが、簡単な情報収集なら十分することができる無料Webスクレイピングツールもあります。

代表的な無料Webスクレイピングツールには以下のようなものがあります。

- Scraper:Chrome拡張機能として、簡単なスクレイピング作業をすることができるツール。簡単な構造のWebページのみデータの抽出が可能です。

- ScrapeStorm:URLを入力するだけで、自動でWebサイトのデータを識別し、抽出をすることができるツール。データの抽出を自動化するだけでなく、整理することもできます。

スクレイピングを行う際の注意点

Webサイトの情報取得にスクレイピングを活用することで、様々な情報を効率よく収集することができます。これが自身の管理下にあるWebサイトであれば構いませんが、他人が運営・管理する既存のWebサイトの情報を取得する場合は、少なくとも以下の3つのことに注意をしておく必要があります。

利用規約に抵触してないかを確認する

Webサイトによっては、個人情報の保護などの観点から、サイト情報を抽出して解析等を行うことを利用規約で禁止にしている場合があります。

利用規約に違反してしまうと裁判沙汰になってしまう可能性もあるため、事前にしっかりと確認しておくようにしましょう。

違法性がないか慎重にデータを扱う

データの取り扱いに関して、著作権の1つである「複製権」や、著作者のデータを財産として保護するための「翻案権」など様々な法律が定められています。

法律に違反しないように注意をして、データを取り扱うようにしましょう。

サイト側に負荷がかからないよう配慮する

スクレイピングでは、プログラムがサイトにアクセスをして情報を取得するため、あまりに多くのデータを一度に取得しようとすると、サイトのサーバーに負荷をかけてしまいます。

したがって、サイトのサーバーにアクセスする際は、最低1秒以上間隔を空けるなど配慮をするようにしましょう。

まとめ

PythonのWebスクレイピングに関して、活用方法から利用手順、注意点まで詳しく解説しました。

Webスクレイピングは、Webサイトから効率よく情報を取得することができるため非常に便利ですが、活用する際は利用規約や法律、サイト側の負荷などに気をつけるようにしましょう。

Pythonの基礎についてまとめた記事もありますので、そちらも合わせて参考にしてみてください。

【保存版】Python配列基礎知識のまとめ!初心者必見

Pythonにおけるfor文を使ったループ処理の作り方を解説!